書-深度學習的數學

將惡魔翻譯成神經網路

模型的合理性

惡魔的人數

自學的神經網路

將惡魔翻譯成神經網路

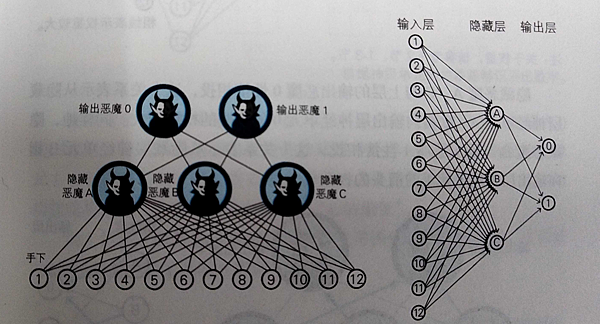

上一篇用惡魔來講手寫辨識的過程,那這次是要把惡魔作為神經網路來描述。

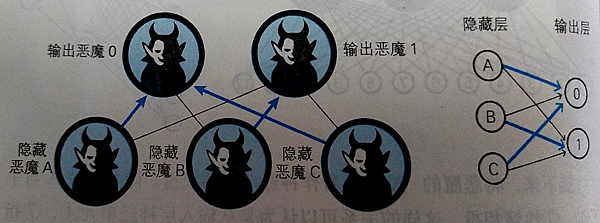

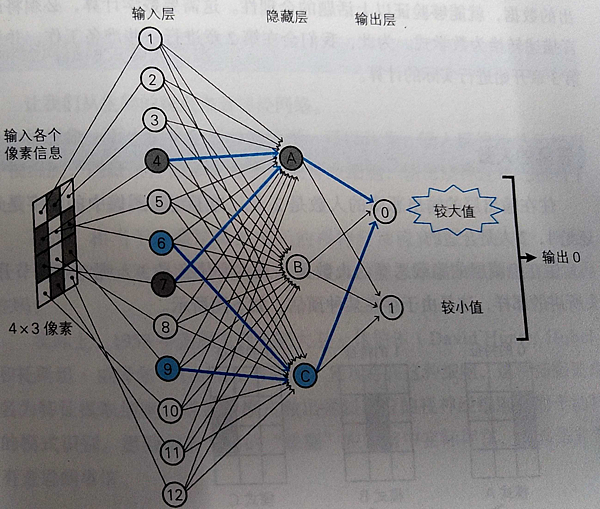

首先,先來看把惡魔組織的架構改為神經網路,小惡魔為輸入層的12神經元,隱藏惡魔為隱藏層的3個神經元,輸出惡魔為輸出層的2個神經元0、1。

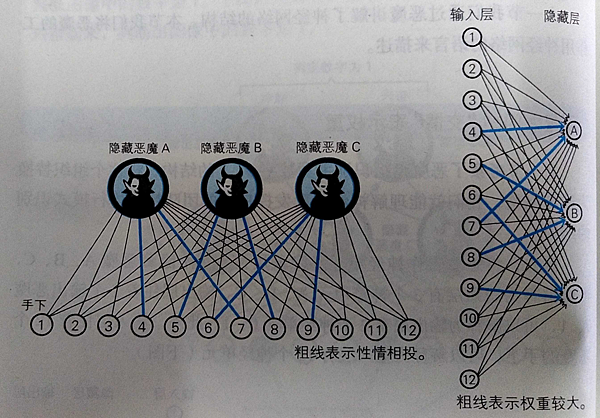

接下來來看惡魔之間有一腿的權重,有一腿的權重值會比較大,會實際影響到結果的。

丟一張手寫數字0,因為隱藏層A、C輸出較大,輸出層0的值較大所以辨識為0。

偏置的部分,以上面的為例,A神經元有連接12個輸入,為了防止其他不重要的輸入影響到結果,所以會加一個偏置來防止輸出。

模型的合理性

權重、偏置、函數的設置是影響到神經網路的運作,但是要讓他'正常'的運作也不是一件簡單的事情,因為深度學習就是算數學,不要說出'數學'沒那麼重要這種鳥話,當然每個人的數學有好有壞,只能盡量去學。

惡魔的人數

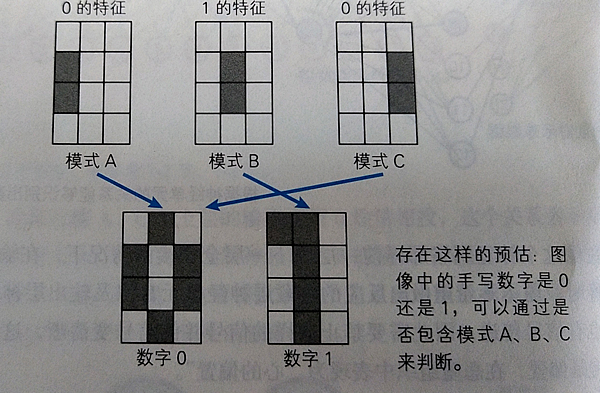

輸出層有2個人,來判斷0、1。

隱藏層有3人,因為要特別去取得輸入的特徵。

自學的神經網路

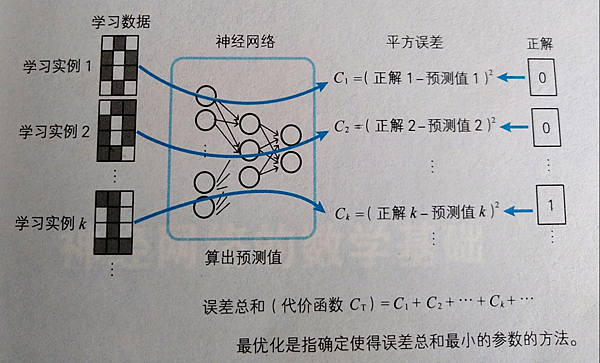

接下來來說神經網路是怎麼來決定權重的大小。神經網路分為監督學習與非監督學習,監督學習就是先給予數據,這些數據稱為學習數據,是為了確定權重和偏置的值。

那如何學習呢?就是讓預測與正確之間的誤差和達到最小,這個步驟成為最優化,預測和正確的誤差總和,有很多種算法,那這本書會用誤差的平方(稱平方誤差),然後再相加。

這個誤差總合稱為代價函數(cost function)用CT表示(T為Total)。利用平方誤差來確定參數在數學上稱為最小二乘法,在統計學回歸分析中常規的手段。

文章標籤

全站熱搜